本地部署 DeepSeek R1/V3 满血版本

本地部署:有点快,缺点模型是蒸馏过

Ollama 下载安装

Ollama 是一个轻量级的本地AI模型运行框架,可在本地运行各种开源大语言模型(如Llama、Mistral等)

浏览器输入网址:https://ollama.com/

选择一个系统进行下载

我这里是 Mac,直接下载就行

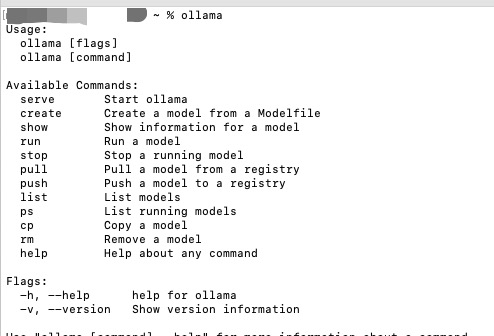

安装之后,Ollama已经运行了,它是CMD命令工具,我们可以在命令行输入ollama来验证,是否安装成功

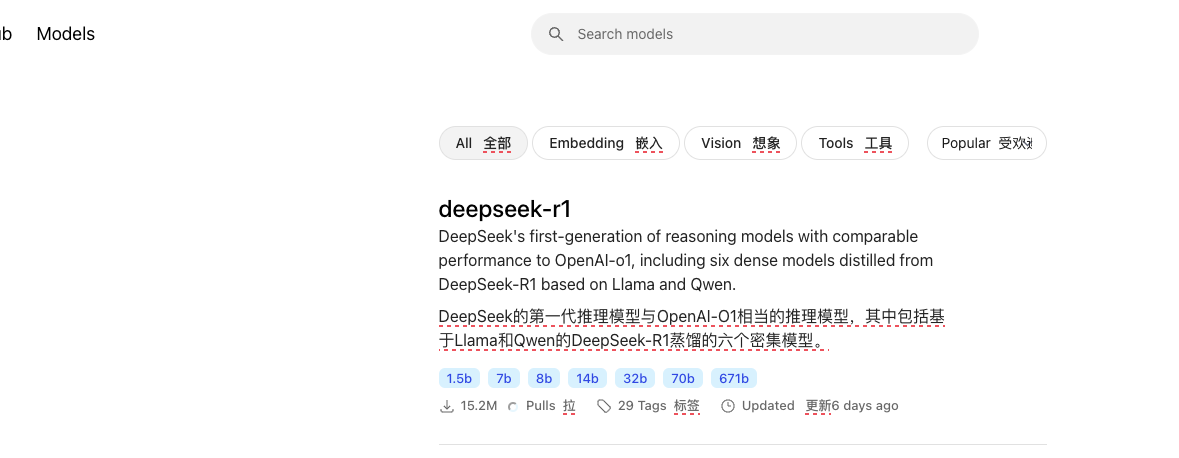

安装DeepSeek-r1模型 还是在刚才的Ollama网站,选择Model模块,选择deepseek-r1这个模型

可以先试试 1.b 模型,在命令行输出 ollama run deepseek-r1:1.5b

接着就是漫长的等待,十几分钟就能下载完成

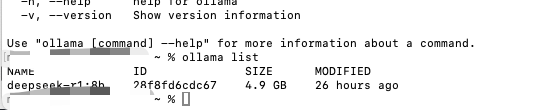

下载完成后会提示 success, 也可以输入 ollama list 检查下载的模型

当然,你也可以下载我这个版本,或者你想删除模型,可以输入 ollama rm <模型 Name>

运行命令: ollama run deepseek-r1:8b

就能直接在 CMD 黑框框内聊天啦。

第三方 客户端使用

当然有个客户端使用是更好的

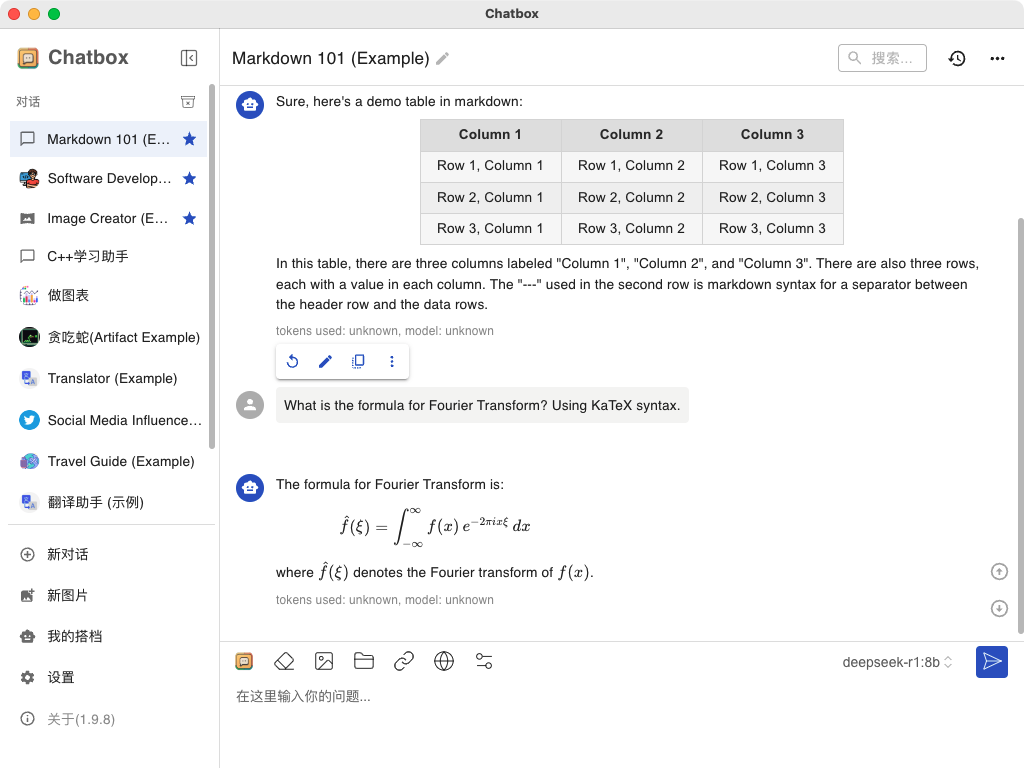

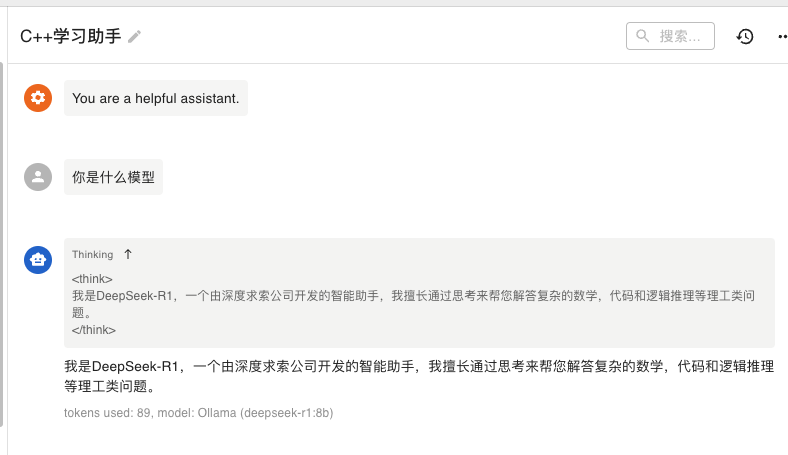

这里体验了 ChatBox Al

下载安装打开

进入设置页面,按照我这个配置就行

接着就可以愉快的使用了。

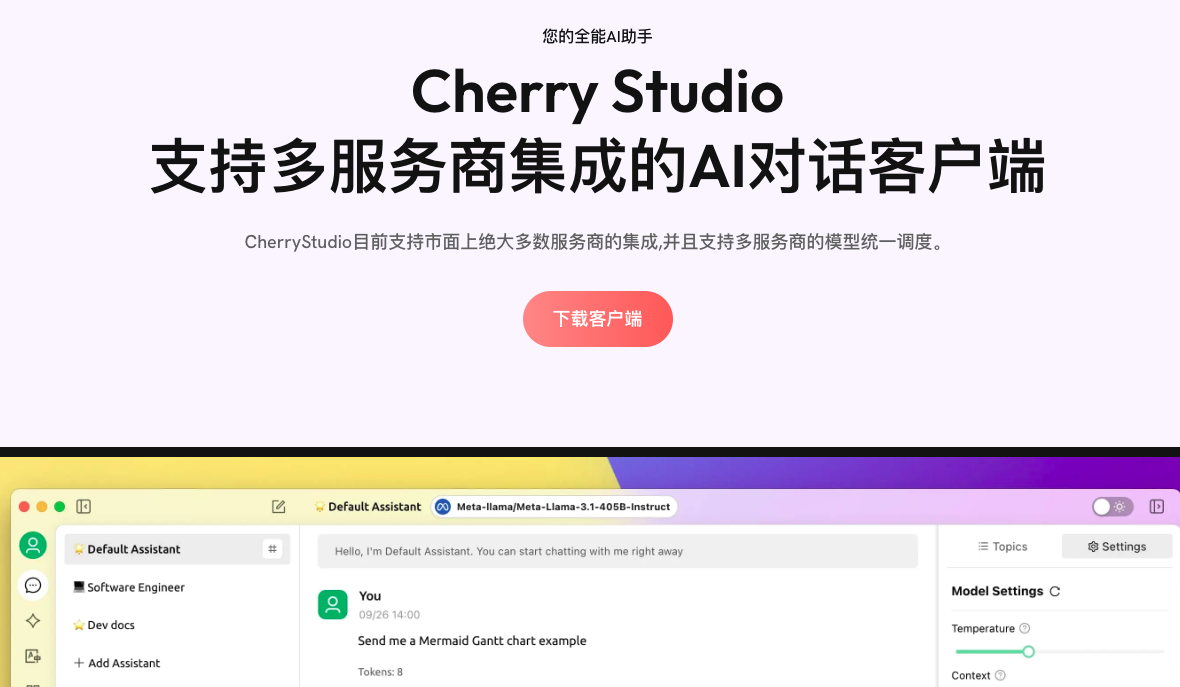

还有一个 Cherry Studio

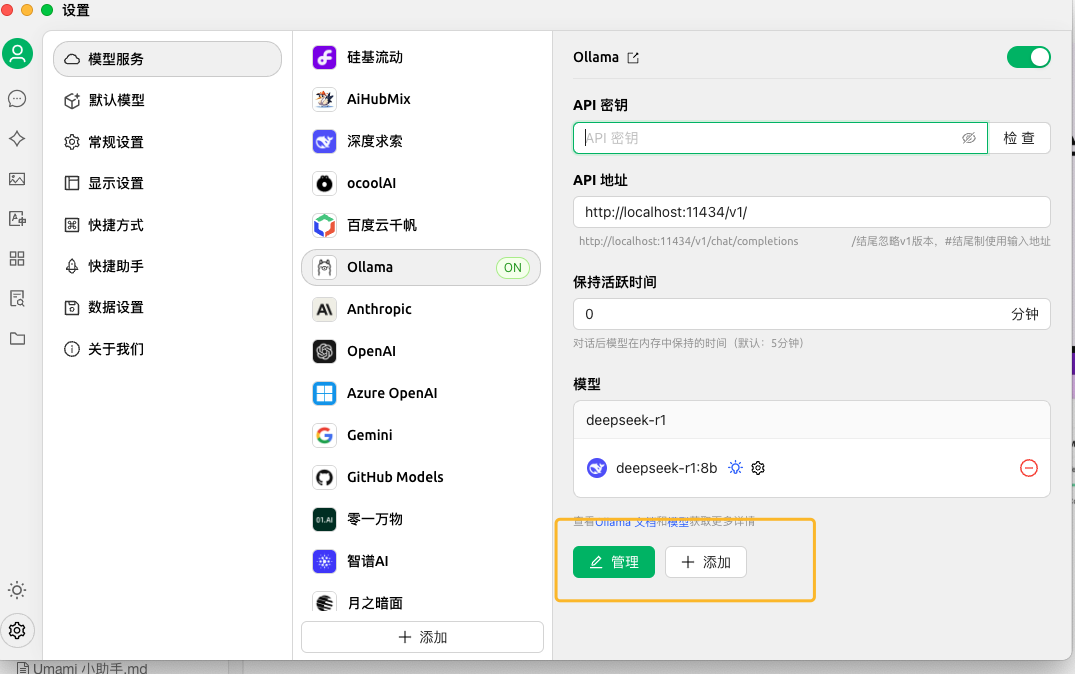

配置的话如下:

需要管理添加上模型

聊天需要左上角选择模型

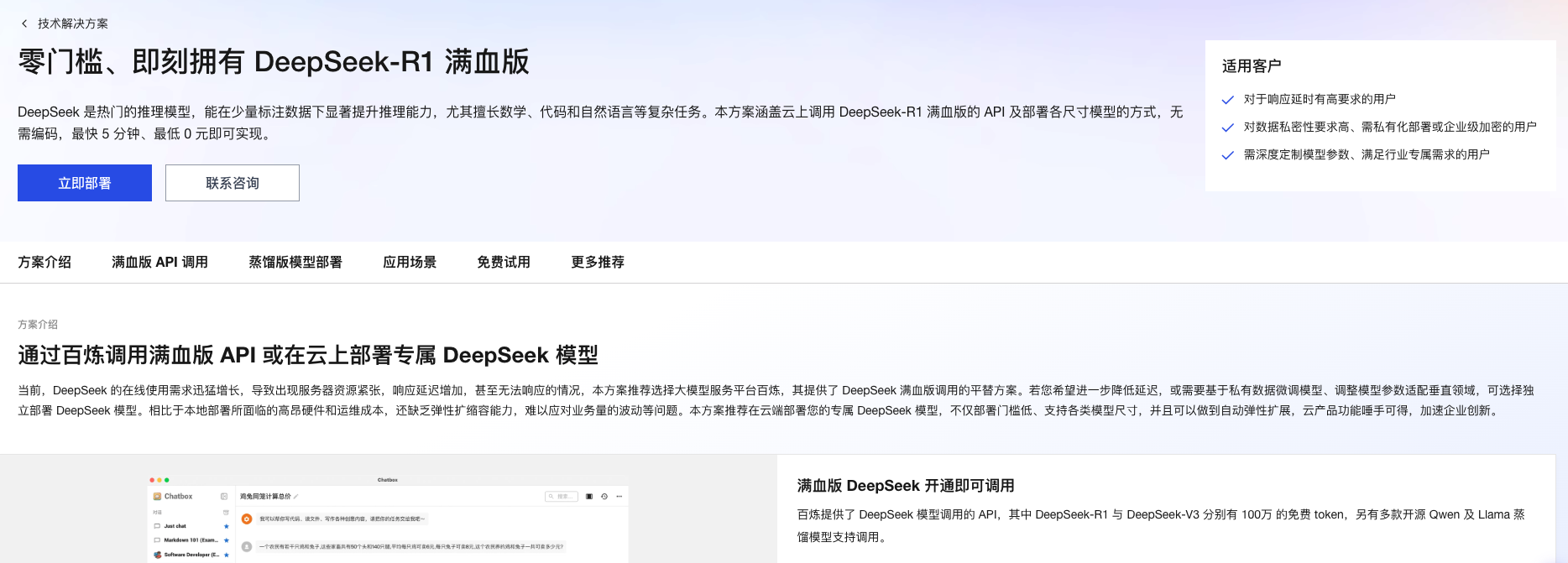

白嫖云厂商免费满血版本

腾讯云

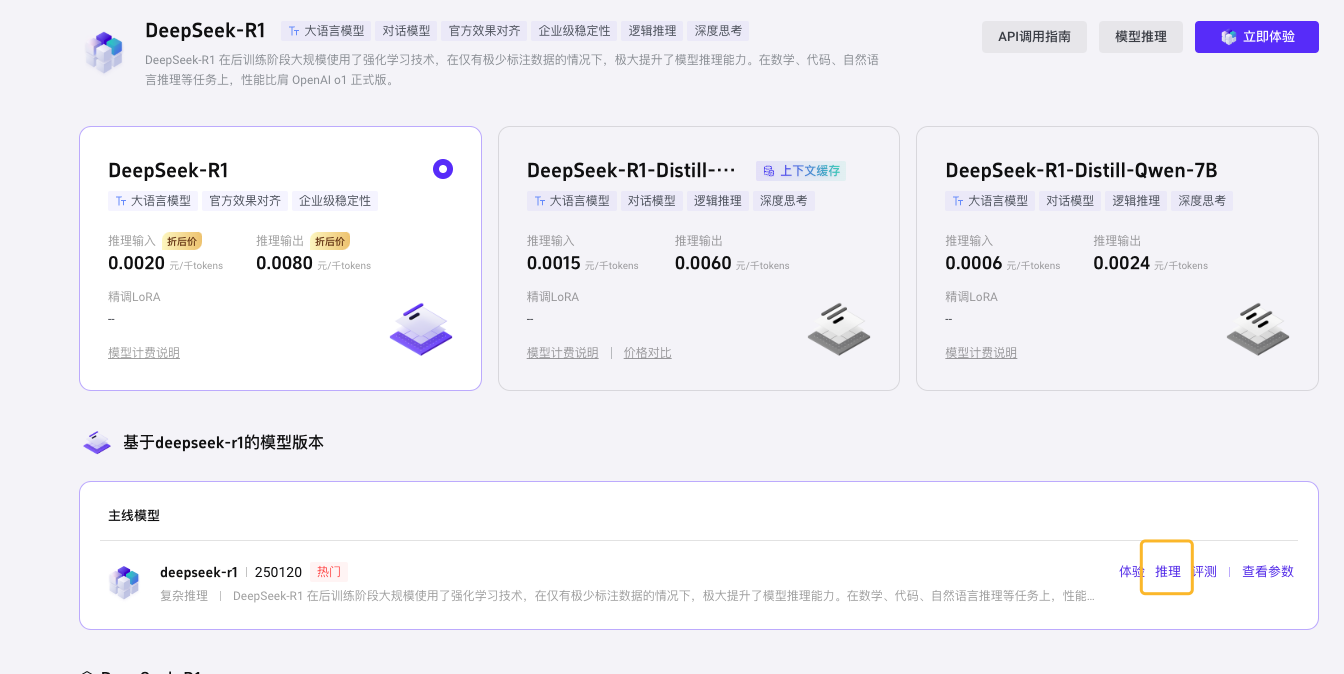

阿里云

腾讯云 元宝

腾讯主力AI应用「元宝」宣布接入Deepseek-R1满血版

测试速度好像没有官方的快

火山引擎

火山云联网

1. API key

点击推理后,进入 API 创建页面,不用修改信息,确认接入 (免费 50 万次 token)

进入后选择 API 调用,选着这个 ID,复制

选着 API Key 创建,并复制使用,只需要复制 key,不需要 export

火山云调用地址:

https://ark.cn-beijing.volces.com/api/v3

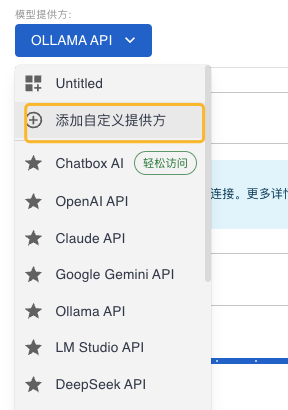

在 CatBox 内配置 R1APi,添加自定义提供方

分别填写

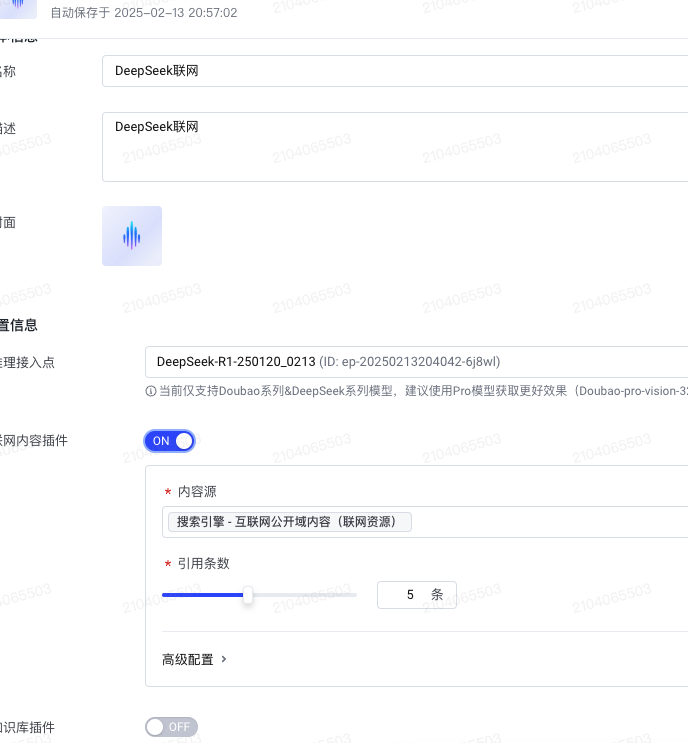

联网版本配置:

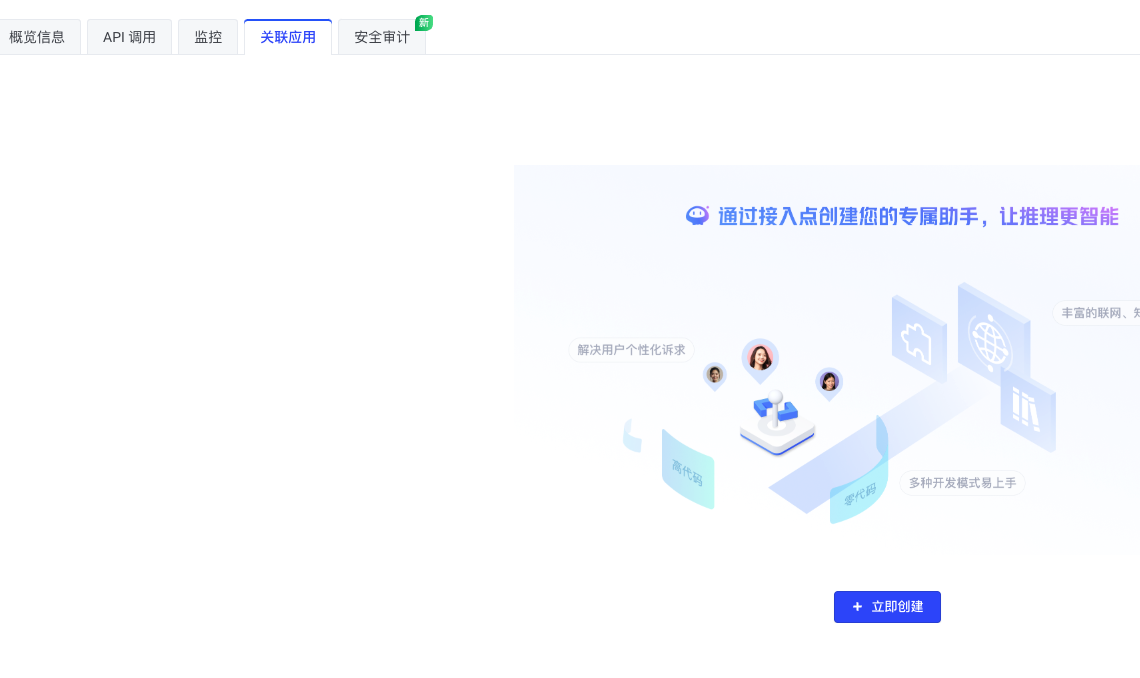

首先在配置上面选着关联应用,并创建,选择 零代码 单聊

需要开通联网内容插件

配置完成,点击发布, 复制应用名称下面的 bot ID, 在右边有个 API 调用指南,获取 API KEY

调用地址:

https://ark.cn-beijing.volces.com/api/v3/bots

Chat Box Al 配置

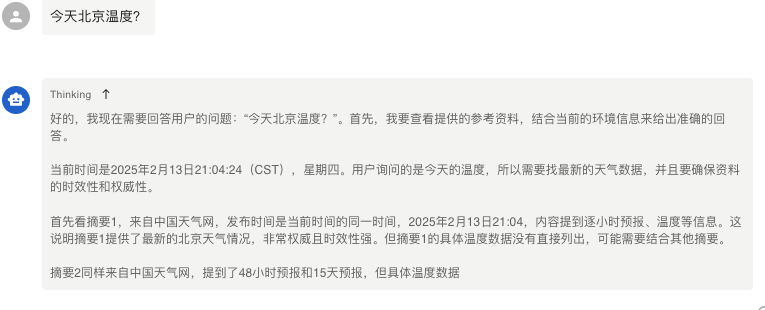

实验一下,结果成功:

哈哈刚发完这个文章,网站的广告就变成这个了,很有趣!!

版权属于:Monster_4y

本文链接:https://blog.zmonster.top/125.html

转载时须注明出处及本声明